Las gafas inteligentes Ray-Ban de Meta tendrán una versión beta en los EE. UU. que conectará la cámara del dispositivo al reconocimiento de objetos. Esto será impulsado por Inteligencia Artificial, apoyado también en parte por Bing de Microsoft.

Meta lanzó las gafas inteligentes Ray-Ban en octubre, justo después de que lanzara su último casco de realidad virtual, las Quest 3.

Estas gafas son una continuación de segunda generación de las gafas Ray-Ban Stories de Facebook. Originalmente lanzadas en 2021, esta nueva iteración introduce cámaras, audio y más opciones de diseño.

Aun no incluyen pantallas para la entrada del usuario, así que en lugar de eso se maneja por un asistente de voz o mediante toques en los puntales. Con ello se pueden tomar fotografías, videos y escuchar música.

A través de un post en Instagram, Andrew Bosworth, el CTO de Meta, anunció una AI multimodal que usará la cámara del dispositivo para nuevas funciones. Esto permite que se haga el reconocimiento de objetos impulsado por IA.

Ver esta publicación en Instagram

Estas nuevas funciones están siendo implementadas en Estados Unidos para los usuarios que hayan entrado al acceso anticipado.

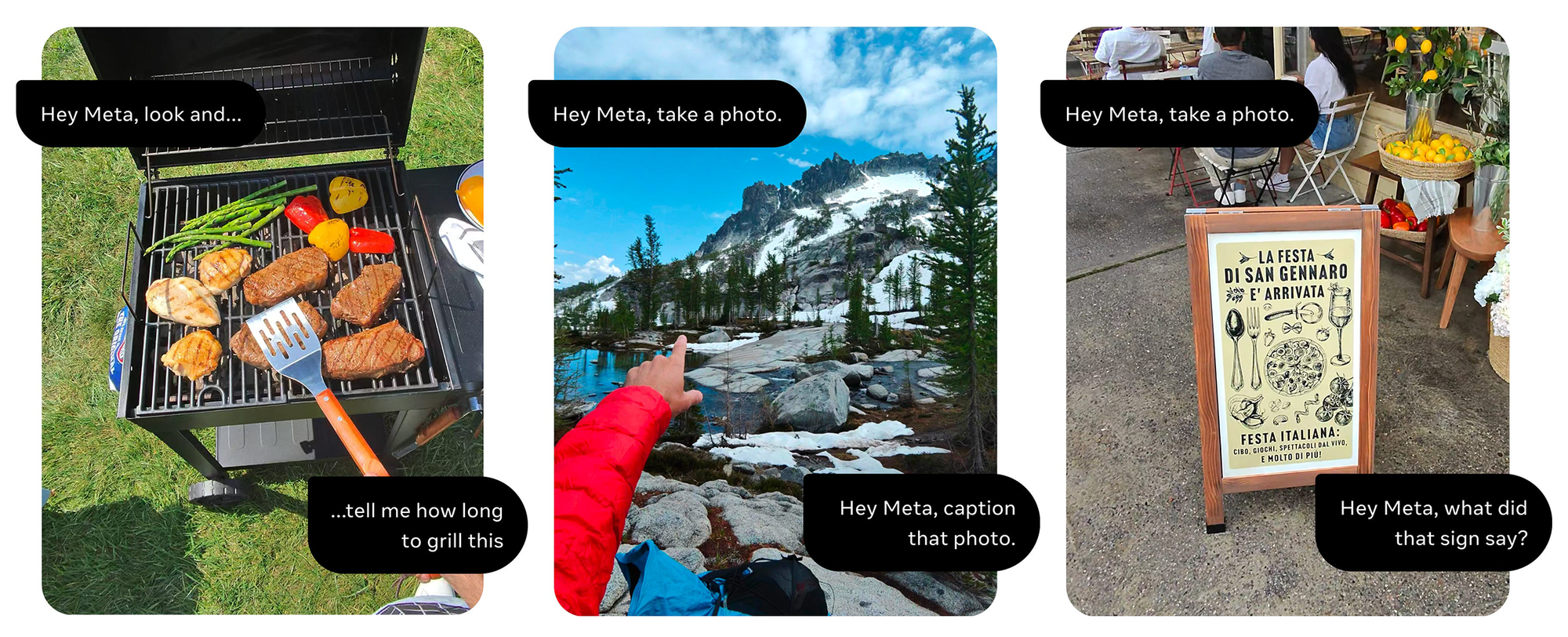

De esta forma se amplía la funcionalidad el asistente de AI ya que permite que Meta haga cosas como «Mira y dime lo que ves». Así lo demuestra Bosworth en la publicación de Instagram.

Otras cosas que se pueden hacer es realizar preguntas sobre las fotos que se han tomado. Por ejemplo responder preguntas sobre lo que uno está cocinando, sugerir un título para una foto o incluso traducir un cartel o letrero en otro idioma.

La compañía asegura que estas son algunas cosas que se pueden hacer y que todavía espera ampliar las funciones.

Para poder unirse al programa de acceso anticipado, si es que se esta en Estados Unidos, solo es necesario abrir Meta View en el teléfono. Luego, ir y tocar el ícono de ajustes en la parte inferior derecha. Por ultimo, deslizar hacia abajo y tocar ‘Acceso anticipado’.